Training van AI kan echt slimmer en sneller

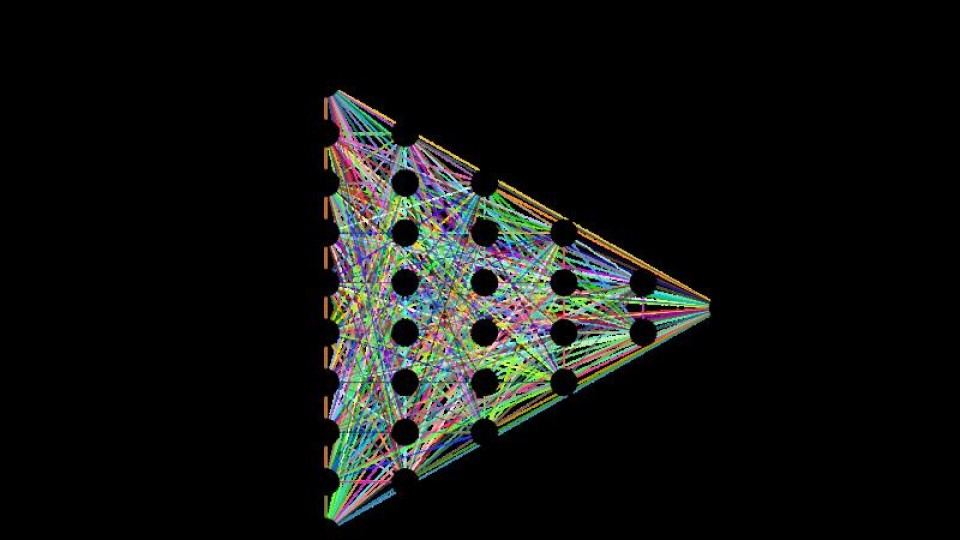

Het trainen van een neuraal netwerk, bijvoorbeeld in het geval van deep learning, komt neer op het in kleine brokjes opdelen van een databestand en filteren Zo wordt bijvoorbeeld een plaatje opgeknipt in blokken opeenvolgende pixels. Die blokken - en dat zijn er enkele tienduizenden tot vele miljoenen - gaan vervolgens door een serie opeenvolgende rekenfilters. De resultaten gaan door een tweede set filters. Dat proces wordt in herhaald tot alle datablokken door alle filters zijn gehaald en het systeem tot een conclusie komt. Dat moment wordt de 'epoch' genoemd.

In een reguliere training volgt een fine-tuningsproces waarbij enkele honderden epochs worden afgerond met dezelfde data. Heel veel datablokken zijn echter identiek en voegen niets toe aan het leerproces. Denk in het voorbeeld van een afbeelding aan vlakken blauwe lucht in dezelfde afbeelding of in een andere afbeelding in de dataset.

Wat is identiek?

Door vergelijkbare datablokken in de dataset weg te filteren kan het proces aanzienlijk worden vereenvoudigd, hebben onderzoekers van de North Carolina State University aangetoond. Zij moesten echter wel twee problemen oplossen. Hoe groot moeten de datablokken zijn voor de beste trainingsomstandigheden en wat is de beste drempelwaarde voor datablokken om als 'identiek' te kunnen worden aangemerkt.

Uit het onderzoek bleek dat het beste resultaat werd bereikt door met relatief grote blokken te beginnen en de drempelwaarde laag in te stellen. In de vervolgstappen konden de blokken dan kleiner gemaakt worden en de eisen op te schroeven met betrekking tot de mate van gelijkheid. Uiteindelijk konden ze dat proces in een adaptief algoritme - Adaptive Deep Reuse - vastleggen dat automatisch de veranderingen aanbrengt tijdens het trainingsproces.

Hoe groter hoe beter

De onderzoekers hebben vervolgens het algoritme getest met verschillende bekende deep learning netwerken en datasets. Het bleek dat hoe groter het neuraal netwerk is, hoe groter het effect van Adaptive Deep Reuse op de trainingstijd. AlexNet had bijvoorbeeld 69 procent minder tijd nodig en CifarNet 63 procent zonder verlies aan accuratesse. AlexNet is aanzienlijk groter dan CifarNet.

De onderzoekers Hui Guan en Lin Ning presenteren hun resultaten deze week op de 35th IEEE International Conference on Data Engineering in het Chinese Macau.

Reacties

Om een reactie achter te laten is een account vereist.

Inloggen Word abonnee