Deepfakes komen steeds dichter bij de realiteit

Trend Micro waarschuwt al een aantal jaar voor de groeiende technische verfijning van ‘deepfakes’ - AI-powered audio en video content die ontworpen is om gebruikers te doen geloven dat het om een echt persoon gaat. Helaas laten recente gebeurtenissen in Nederland zien dat de technologie die gebruikt wordt bij deepfakes zich de laatste jaren enorm snel heeft ontwikkeld. Nu de realiteit van geloofwaardige deepfakes nadert, is het aan de cybersecurity-industrie, politici en overheden om zich hierop voor te bereiden. Zo worden er stappen ondernomen door onder meer de Europese Unie en de Amerikaanse FTC om mogelijk kwaadaardig gebruik en misbruik van AI te beteugelen via nieuwe wetgeving.

Daarnaast is het tijd voor security-leiders om deepfakes in hun dreigingsmodellen te bouwen, en voor de industrie om manieren te onderzoeken om dergelijke oplichting aan te pakken.

Wat zijn deepfakes?

Om te begrijpen wat deepfakes zijn, kijken we allereerst naar het woord zelf: dit is een combinatie van de machine learning-subset ‘deep learning’ en ‘fake media’. Er zijn verschillende manieren om deze content te maken, maar in essentie gaat het om deep neural network technologie, ook wel bekend als ‘autoencoder’, die getraind wordt om video input te comprimeren en opnieuw op te bouwen. Door deze technologie toe te passen op video streams van twee verschillende gezichten, en de streams vervolgens om te wisselen, is het mogelijk om de gezichtsuitdrukkingen en gebaren van persoon A op die van persoon B te laten lijken. Met dergelijk bedrog kun je iemand dus van alles laten zeggen.

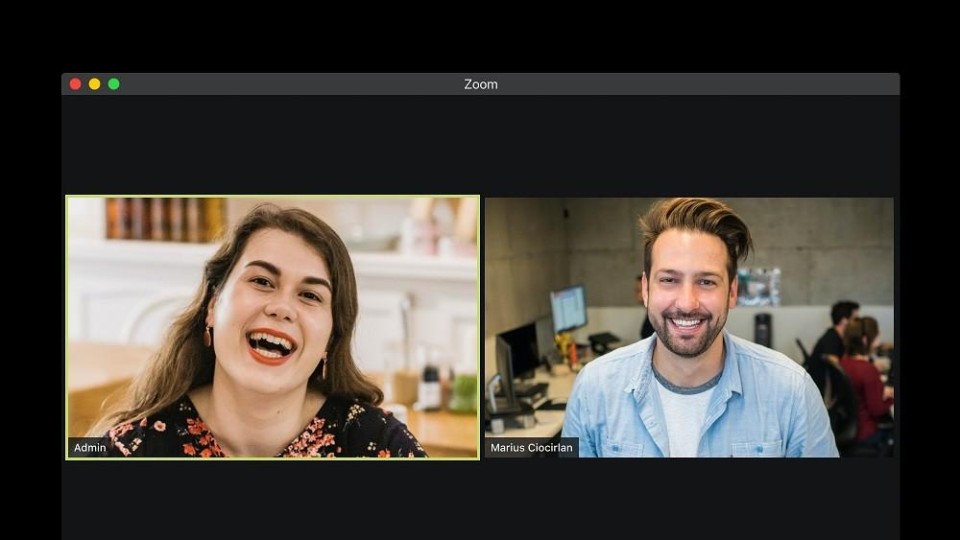

Een recent voorbeeld van het gebruik van deepfake-technologie vinden we in de video call die ambtenaren uit verschillende landen hadden met ‘Leonid Volkov’, de Chief of Staff van de Russische oppositieleider Alexei Navalny. Dit gesprek vond onder andere plaats met het VK, Litouwen, Estland, Letland en Nederland. Een screenshot die online is gezet door een van de betrokken politici laat zien hoe accuraat de fake video was.

Verder komen er ook steeds nieuwe Proof-of-Concept-toepassingen van deepfakes aan het licht, wat vragen doet rijzen over hoe deze technologie zich in de toekomst zou kunnen ontwikkelen.

Tijd om alarm te slaan

De mogelijkheden om desinformatie te verspreiden op de allerhoogste overheidsniveaus zijn bijna eindeloos voor degenen die in staat zijn om effectieve deepfake-technologie toe te passen. Nog zorgelijker is dat bewerkte video’s ook gebruikt kunnen worden door cybercriminelen om bijvoorbeeld kiesgedrag bij een verkiezing te beïnvloeden.

En dat is niet alles. Zoals we in 2018 al eens uitlegden, kan dezelfde technologie ook gebruikt worden om Business Email Compromise (BEC) te ondersteunen en zo financiële teams te misleiden om grote sommen geld over te maken naar derde partijen. Stel je eens voor dat een CEO op Zoom een bevel geeft om geld over te maken. Dat kan erg overtuigend zijn voor veel werknemers. Dit heeft zelfs al eens plaatsgevonden met deepfake audio, waar een Britse executive werd misleid om honderdduizenden ponden over te maken. Een van onze voorspellingen voor 2020 was dan ook dat deepfakes vaker ingezet zouden worden voor bedrijfsfraude.

Wat gebeurt er nu?

Financieel gemotiveerde afpersing, social engineering en operaties gericht op het destabiliseren van de democratie zijn slechts het begin. Deze expert claimde recent dat naarmate AI-technologie geavanceerder en alomtegenwoordig wordt, de kracht om zeer overtuigende deepfakes te creëren halverwege dit decennium in handen zou kunnen zijn van elke smartphonegebruiker. Dus wat kunnen we eraan doen?

Security-teams kunnen en moeten zich hierop voorbereiden. Dit betekent dat waarschuwingen zoals die van ons gehoord moeten worden om te begrijpen hoe deze technologie gebruikt kan worden voor kwaadaardige doeleinden. We presenteerden recentelijk dit onderzoek over het gebruik en misbruik van AI in samenwerking met de VN en Europol. Dit is een goed startpunt.

We kijken ook verder in de toekomst om te anticiperen hoe AI en deepfakes onderdeel kunnen worden van een cyber arms race in Project 2030. Voor nu moeten we in ieder geval beter worden in het opleiden van werknemers om vervalsingen te kunnen herkennen en tools gebruiken om hetzelfde te doen. We hebben een lange weg te gaan met betrekking tot kwaadaardig gebruik van AI, maar door nu al concrete stappen te nemen om deze dreigingen beter te begrijpen kunnen we tactisch voordeel behalen. Een gewaarschuwd mens telt voor twee!

Reacties

Om een reactie achter te laten is een account vereist.

Inloggen Word abonnee