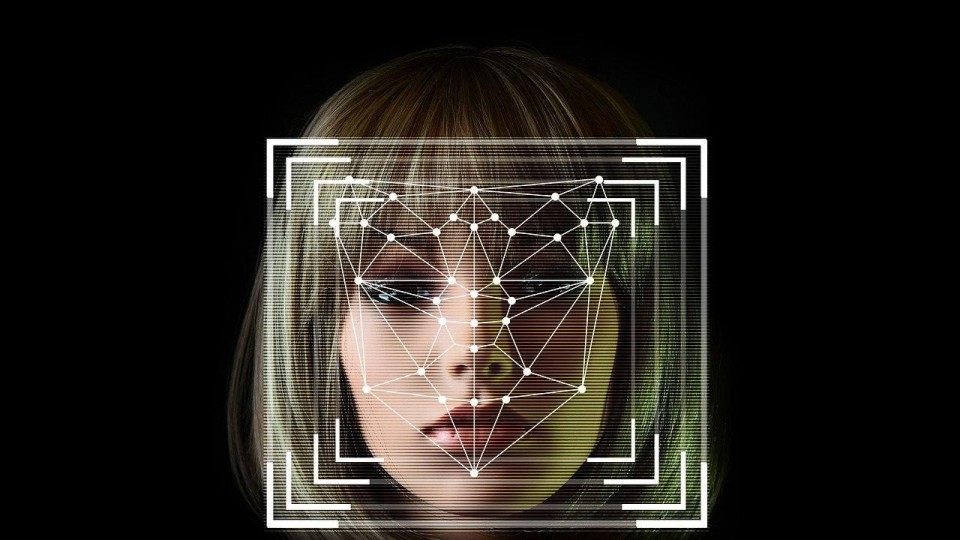

Liplezen levert verbetering van spraakherkenning, zegt Meta

Dat laatste gegeven heeft Meta - het moederbedrijf van Facebook - als uitgangspunt genomen voor het systeem Audio-Visual Hidden Unit BERT (AV-HuBERT). Het bedrijf claimt door het systeem te laten liplezen tot wel 75% betere transcripties te komen. Vooral in situaties waar achtergrondgeluiden een rol spelen, zoals op een feestje of buiten op een markt, bewijst de gecombineerde aanpak zijn voordelen.

Het voordeel van AV-HuBERT is bovendien dat het maar een tiende van de gelabelde data nodig heeft om te trainen ten opzichte van eerdere AV-spraakherkenningssystemen. Dat biedt veel kansen voor het gebruik bij talen waarvan niet zoveel gelabelde audiofragmenten beschikbaar zijn, meldt Venturebeat.

De onderzoekers van Meta zijn dus niet de eersten die het voordeel zagen van het betrekken van liplezen bij de ontwikkeling van spraakherkenningssystemen. Ook aan de universiteit van Oxford en bij Deep Mind van Google-moederbedrijf Alphabet, zijn dergelijke systemen ontwikkeld, maar deze beperkten zich tot het liplezen zonder er audio bij te betrekken. Met deze modellen zijn heel goede resultaten behaald. Deepmind transcribeerde bij TV-shows de helft van de woorden en maakte 4 keer minder fouten dan een menselijke expert. Het probleem met deze systemen is echter dat het vocabulaire dat ze kunnen herkennen beperkt is en er uitgebreide gelabelde datasets nodig waren voor training.

Beter verbanden leggen

Bij AV-HuBERT is gekozen voor een zelflerend systeem waarbij de kunstmatige intelligentie zelf ongeclassificeerde data indeelt in klassen. Bovendien werd dus gebruik gemaakt van zowel de video als de audio 'cue'. Daardoor kon het systeem verbanden leggen tussen de gesproken woorden en de lipbewegingen.

Meta ziet veel toepassingen. Niet alleen kan de transcriptie van vergaderingen verbeteren, maar het systeem zou ook kunnen helpen bij het ontdekken van deep-fakes, omdat het gesproken woord dan niet exact overeenkomt met de bewegingen van het gezicht.

Bias ingebakken

Ethici merken wel op dat een nadeel van het systeem is dat het niet goed werkt bij het herkennen van gesprekken met mensen die als gevolg van bijvoorbeeld een spraakgebrek of aangeboren afwijking een andere mimiek hebben tijdens het spreken.

Reacties

Om een reactie achter te laten is een account vereist.

Inloggen Word abonnee